Американская компания OpenAI, разработчик чат-бота GPT-4, провела исследование его эффективности для создания биологического оружия.

Для этого компания проверила продуктивность двух групп экспертов: одна пользовалась для поиска информации на эту тему в интернете, а вторая использовала интернет и специальный вариант GPT-4, который отличается от версии, доступной для общественности, отсутствием дополнительных мер безопасности.

Для обеих групп выполнение задания по заданной теме заняло около получаса. Группа, пользовавшаяся ИИ, смогла предоставить, как говорится в пресс-релизе OpenAI, «более точные результаты». Кроме этого, группа с GPT-4 смогла найти более полную информацию по теме.

Посвященная этому исследованию публикация на сайте компании носит вполне невинное название Building an early warning system for LLM-aided biological threat creation («Создание системы раннего предупреждения о создании биологической угрозы с помощью LLM»).

Сообщается, что в эксперименте «участвовало 100 человек, в том числе а) 50 экспертов по биологии с докторской степенью и профессиональным опытом работы в мокрых лабораториях и б) 50 участников студенческого уровня, прошедших как минимум один университетский курс биологии. Каждую группу участников случайным образом распределяли либо в контрольную группу, которая имела доступ только к интернету, либо в группу лечения, которая, помимо интернета, имела доступ к GPT-4. Затем каждому участнику было предложено выполнить ряд задач, охватывающих аспекты сквозного процесса создания биологической угрозы. Насколько нам известно, это крупнейшая на сегодняшний день человеческая оценка воздействия ИИ на информацию о биорисках».

На самом деле, эксперимент, проведенный OpenAI, продемонстрировал, что команда из 50 профессоров биологии и студентов биофака за полчаса может разработать новое биологическое оружие. А если использовать чат-бот GPR-4, то результаты этой, с позволения сказать, научной работы могут быть, как утверждают в OpenAI, несколько лучше.

Со вторым утверждением согласиться ни в коем случае нельзя. Можно предположить, что реальные результаты эксперимента были засекречены, а с участников была взята подписка о неразглашении.

Дело в том, что еще в апреле 2022 года американская компания Collaborations Pharmaceuticals в ходе международной конференции по безопасности Convergence, организованной Швейцарским федеральным институтом ядерной, биологической и химической защиты, продемонстрировала свою модель ИИ под названием MegaSyn не в обычном режиме работы, который заключается в обнаружении токсичности в молекулах, чтобы избежать ее, а в противоположном режиме.

В эксперименте токсичные молекулы сохранялись, а не удалялись. Модель также была обучена объединять эти молекулы в комбинации. В результате всего лишь за шесть часов было создано 40 тысяч видов биологического оружия.

Перед экспериментом исследователи обучили MegaSyn с помощью баз данных молекул, входящих в лекарства, создавать нечто похожее на сильнодействующий нервно-паралитический газ VX.

Многие из полученных соединений были более токсичными, чем VX. В результате авторы исследования его засекретили и долго обсуждали, стоит ли вообще обнародовать эти результаты.

Стоит ли их благодарить, что не выложили в открытый доступ формулы смертельных видов химического и биологического оружия?

«Изменив использование наших моделей машинного обучения, мы превратили нашу безобидную генеративную модель из полезного медицинского инструмента в генератор потенциально смертельных молекул», – объясняют исследователи.

В интервью The Verge Фабио Урбина, старший научный сотрудник Collaborations Pharmaceuticals, объяснил, что не нужно многого, чтобы «переключить переключатель» с хорошего ИИ на плохой ИИ.

Заметим, что Collaborations Pharmaceuticals сотрудничает с пентагоновским Агентством по сокращению военных угроз (DTRA), которое финансирует по всему миру американские военные биолаборатории, в которых разрабатываются смертельные штаммы биологического оружия. В 2019 году компания получила от DTRA грант на сумму около $3 млн на якобы благие цели. Похоже, на эти средства и был произведен упомянутый эксперимент, в ходе которого были созданы четыре тысячи видов смертельного биологического оружия с помощью ИИ MegaSyn.

Недаром, этот проект получил название Dr. Evil – «Доктор Зло».

При этом генеративный ИИ MegaSyn, созданный в 2022 году на деньги пентагоновского DTRA, заметно уступает по своим возможностям новинкам от OpenAI и других американских IT- компаний.

Между тем американские власти не устают предупреждать человечество об угрозах, исходящих от искусственного интеллекта.

«ИИ способен принести не только пользу, но и огромный вред: от кибератак с использованием ИИ, масштабы которых превосходят все, что мы видели ранее, до биооружия, созданного ИИ, которое может поставить под угрозу жизни миллионов людей. Эти угрозы часто называют экзистенциальными угрозами ИИ, поскольку они могут поставить под угрозу само существование человечества», – заявила в ноябре прошлого года вице-президент США Камала Харрис, выступая на первом международном саммите по безопасному использованию ИИ в Лондоне.

Между тем именно в США в 2015 году был искусственно создан, как мы писали, зловещий коронавирус.

Его разработала международная группа учёных на территории США в составе 12 американских вирусологов, двух китайских экспертов из Уханьского института вирусологии и одного швейцарского ученого из Цюрихского института биомедицины.

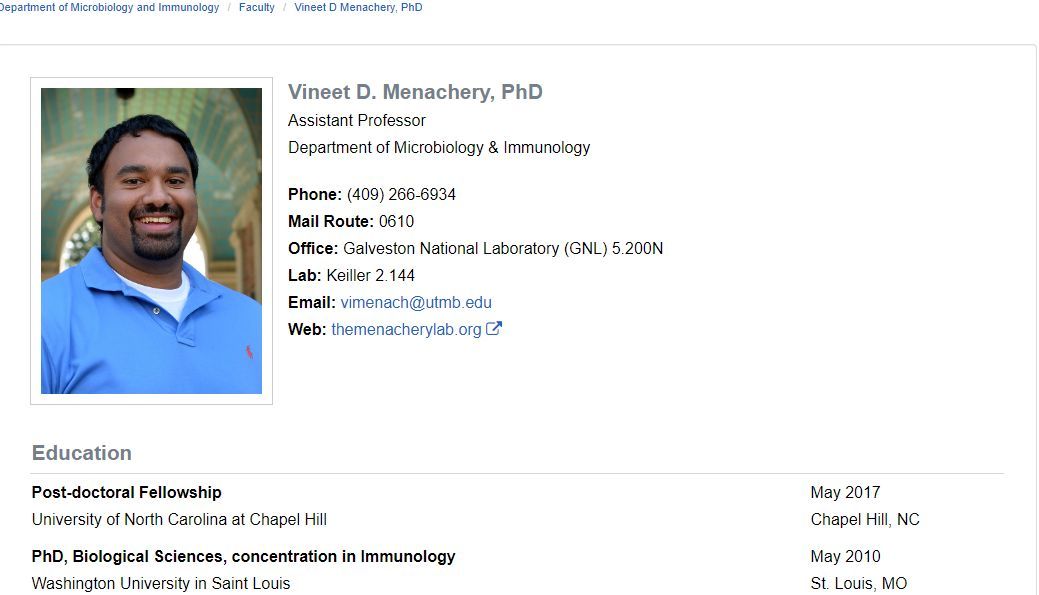

Возглавлял группу Vineet D. Menachery, доцент (assistant professor) ряда университетов США, основное место работы которого Национальная лаборатория Галвестона (Galveston National Laboratory, GNL) в Техасском университете.

9 ноября 2015 года в самом авторитетном в мире медицинском журнале Nature Medicine была опубликована статья A SARS-like cluster of circulating bat coronaviruses shows potential for human emergence (SARS-подобный кластер циркулирующих коронавирусов летучих мышей демонстрирует потенциал появления у человека). Первым в ряду авторов этой статьи стоит Vineet D. Menachery.

Вот что говорится в этой публикации: «Используя систему обратной генетики SARS-CoV2, мы создали и исследовали вирус-химеру, вызывающий всплеск коронавируса летучей мыши SHC014 в адаптированном для мыши остове SARS-CoV».

Авторы объяснили, что ими создан крайне опасный вирус, и объявили, что «появление SARS-CoV ознаменовало новую эру в межвидовой передаче тяжелых респираторных заболеваний с глобализацией, ведущей к быстрому распространению по всему миру и огромным экономическим последствиям».

Данная публикация – убедительное доказательство того, что химерный коронавирус SARS-CoV был искусственно создан на территории США под руководством известного американского вирусолога из лаборатории Галвестона.

Исследования этой лаборатории финансируются, как пишет итальянский эксперт Беатриса Кавалли, «Пентагоном, центрами по контролю и профилактике заболеваний США (CDC), федеральными агентствами и, само собой разумеется, биофармацевтической промышленностью».

Профессор микробиологии, заместитель директора Галвестонской лаборатории Джеймс Ледюк руководит рядом проектов DTRA, которая финансирует упомянутую выше компанию Collaborations Pharmaceuticals, а также разработку биологического оружия в военных биолабораториях по всему миру.

По оценке аналитиков российской Академии военных наук, усилия американских компаний, разработчиков продвинутых систем генеративного ИИ в ближайшее время могут быть ориентированы на создание высокоэффективных летальных генетических/расовых вирусов на основе механизма так называемой РНК-интерференции.

Создание такого оружия стало возможным с открытием механизма так называемой РНК-интерференции. Эта технология была открыта в 1998 году американскими учеными Эндрю Файером и Крейгом Мелло, в 2006 году они получили за неё Нобелевскую премию. При помощи РНК-интерференции можно влиять на работу генов определённых этнических групп таким образом, что у людей из этой этнической группы или прекращаются тяжёлые болезни (например, артрит), или, наоборот, перестаёт вырабатываться иммунитет против того или иного заболевания.

В докладе Британской медицинской ассоциации (BMA) говорится, что в настоящее время созданы возможности для создания этнического оружия, которое может быть разработано в ближайшем будущем: «Вместо того чтобы специально вызывать токсическое воздействие таких организмов, как сибирская язва, оружие, основанное на новой медицинской технике, называемой РНК-интерференцией, может отключить жизненно важные гены. Если последовательность целевого гена варьируется в двух разных популяциях, этот метод можно использовать для прерывания ключевых функций организма в одной популяции, а не в другой. Если будет затронуто всего лишь 10–20% целевого населения, это приведет к хаосу среди солдат противника на поле боя или во вражеском обществе в целом».

В одном из докладов DTRA, как мы писали, признается, что «существует возможность использования РНК-интерференции для создания биологического оружия».

Американские разработчики всевозможных Dr. Evil Project не устают уверять мировую общественность в своих гуманных устремлениях. На деле же они успешно осваивают ресурсы Пентагона и создают все новые виды смертельного оружия. На поверку прожженные гуманисты из OpenAI своим экспериментом по использованию GPR-4 для разработки биологического оружия успешно застолбили себе не самое последнее место в будущих военных тендерах Пентагона.

Фото: medium.com