Групповое тестирование 35 видеокарт в The Last of Us Part I

The Last of Us Part I представляет собой ремейк одного из самых известных тайтлов последнего десятилетия, который дебютировал на PlayStation 3, затем пережил ремастер для PlayStation 4, и все это время был доступен только владельцам приставок Sony. Однако японцы уже не столь ревностно относятся к своим эксклюзивам, как раньше, и всего через полгода после издания на PlayStation 5 игра была портирована на платформу Windows.

Львиная доля усовершенствований в новой версии The Last of Us по сравнению с оригиналом и его ремастером относится к графике, которая раскрывает возможности PS5 и актуального компьютерного железа. Но, как часто происходит с «чужеродными» проектами, релиз на ПК не прошел гладко для The Last of Us Part I. Покупатели жалуются на длительную подготовку к работе, нестабильность и высокий расход памяти GPU. А главное, даже при условии достаточного объема VRAM это чрезвычайно требовательная игра, которая станет хорошим бенчмарком для видеокарт последнего поколения.

⇡#Настройки качества графики

Несмотря на консольное происхождение, The Last of Us Part I на персоналках открывает перед игроком широкий список индивидуальных настроек графики, которые подчиняются общему четырехпозиционному переключателю. Кроме того, игра поддерживает два метода апскейлинга кадров: FSR 2 и DLSS, но в последнем случае — без функции генерации промежуточных кадров, которая точно пригодилась бы грядущим моделям серии GeForce 40. Еще одна технология, отсутствие которой бросается в глаза, — это трассировка лучей, и студия Naughty Dog не обещает, что она когда-либо вообще появится в игре.

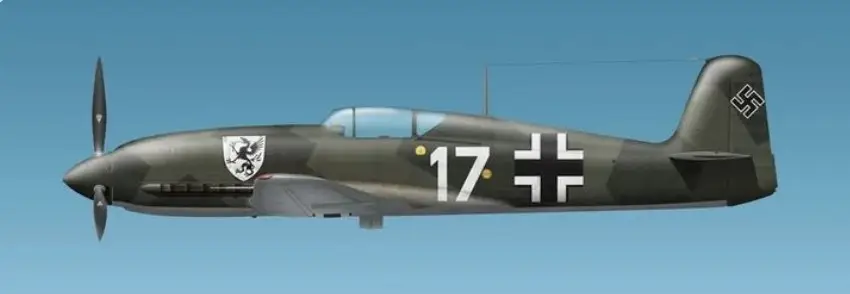

Мы провели тесты видеокарт в трех режимах качества графики: низком, среднем и «ультра», а скриншоты ниже демонстрируют, как меняется изображения в зависимости от настроек.

Low |

Medium |

Ultra |

||

Low |

Medium |

Ultra |

||

Low |

Medium |

Ultra |

||

Low |

Medium |

Ultra |

||

Low |

Medium |

Ultra |

||

Low |

Medium |

Ultra |

||

Low |

Medium |

Ultra |

||

Low |

Medium |

Ultra |

||

Low |

Medium |

Ultra |

||

Low |

Medium |

Ultra |

Прежде чем мы рассмотрим результаты бенчмарков, стоит поговорить о широко известных технических недостатках порта The Last of Us Part I на ПК. Первая неприятность, с которой столкнется геймер, это процесс компиляции шейдеров под архитектуру видеокарты, установленной в компьютере. Компиляция происходит всего один раз, но чрезвычайно медленно даже после обновления игры, которое было нацелено именно на эту проблему. С некоторыми видеокартами процесс занимает в общей сложности больше часа! Во время компиляции можно начать игру, но кадровая частота будет заметно снижена и, возможно, затянется сама подготовка к нормальной работе. Хуже того, периодически компиляция просто не доходит до конца, а игра вылетает — тогда, как правило, все приходится начинать заново.

В связи с этим нам пришлось ограничить список видеокарт, участвующих в тестировании моделями нового и двух предшествующих поколений от NVIDIA и AMD, а также Intel Arс. Устройства, принадлежащие к семействам GeForce 16, GeForce 10, Radeon RX Vega и Radeon RX 500, пришлось оставит на полке, иначе вы бы еще нескоро смогли прочитать эту статью.

Еще одна претензия, которая чаще всего звучит в адрес The Last of Us Part I — это требования к памяти видеокарты, которые превосходят наиболее распространенный сегодня объем 8 Гбайт. Действительно, по данным утилит мониторинга (таких, как MSI Afterburner) общий расход VRAM при максимальных настройках графики превышает 10 Гбайт уже при разрешении 1080p, а в 1440p и 4К стремится к 11 и 13. Конечно, аллокация того или иного объема VRAM не означает, что он действительно используется, а его нехватка оказывает влияние на кадровую частоту, но в случае с The Last of Us Part I это именно так. При игре на максималках ускорители с 8 Гбайт памяти испытывают просадки фреймрейта, заметные невооруженным взглядом. Нам пришлось выбрать для тестов такой отрезок геймплея (в начале истории, миссия The Cargo), который не подразумевает частой смены декораций и максимально сглаживает колебания FPS — иначе результаты повторных измерений на одной и той же видеокарте были слишком непостоянны. Но мы успеем убедиться, что объем VRAM проявляет себя и в усредненных показателях частоты смены кадров.

C настройками эффектов, пониженными до среднего уровня, общий расход VRAM лежит в пределах 8 Гбайт при разрешениях 1080p и 1440p, а на минималках — и в 4К, однако игра выглядит уже совсем не так, как ее задумали разработчики. В отличие от многих других современных тайтлов, разница между ступенями качества графики здесь выражена очень сильно, так что объяснять потребление VRAM исключительно плохой оптимизаций The Last of Us Part I было бы не вполне справедливо.

| Потребление VRAM, Мбайт | |||

|---|---|---|---|

| Качество графики | 1920 × 1080 | 2560 × 1440 | 3840 × 2160 |

| Low | 6 030 | 6 459 | 7 519 |

| Medium | 6 603 | 7 768 | 8 930 |

| Ultra | 10 213 | 10 835 | 12 800 |

⇡#Тестовый стенд, методика тестирования

| Тестовый стенд | |

|---|---|

| CPU | AMD Ryzen 9 5950X (4,4 ГГц, фиксированная тактовая частота всех ядер) |

| Материнская плата | ASUS ROG Strix X570-E Gaming (Resizable BAR вкл.) |

| Оперативная память | G.Skill Trident Z RGB F4-3200C14D-16GTZR, 4 × 8 Гбайт (3600 МТ/с, CL16) |

| ПЗУ | Intel SSD 760p, 2048 Гбайт |

| Блок питания | Corsair AX1200i, 1200 Вт |

| Система охлаждения CPU | Corsair iCUE H115i RGB PRO XT |

| Корпус | Открытый стенд |

| Операционная система | Windows 10 Pro x64 |

| ПО для GPU AMD | |

| Все видеокарты | AMD Radeon Software Adrenalin Edition 23.4.1 |

| ПО для GPU NVIDIA | |

| Все видеокарты | NVIDIA GeForce Game Ready Driver 531.61 |

| ПО для GPU Intel | |

| Все видеокарты | Intel Graphics Driver 31.0.101.4255 |

Тестирование производительности выполнено с помощью утилиты OCAT. Показатели средней и минимальной кадровых частот выводятся из массива времени рендеринга индивидуальных кадров, который игра записывает в файл результатов.

Средняя частота смены кадров на диаграммах является величиной, обратной среднему времени рендеринга кадра. Для оценки минимальной кадровой частоты вычисляется количество кадров, сформированных в каждую секунду теста. Из этого массива чисел берется значение, соответствующее 1-му процентилю распределения.

⇡#Участники тестирования

- AMD Radeon RX 7900 XTX (1720/2499 МГц, 20 Гбит/с, 24 Гбайт);

- AMD Radeon RX 7900 XT (1387/2394 МГц, 20 Гбит/с, 20 Гбайт);

- AMD Radeon RX 6900 XT (1825/2250 МГц, 16 Гбит/с, 16 Гбайт);

- AMD Radeon RX 6800 XT (1825/2250 МГц, 16 Гбит/с, 16 Гбайт);

- AMD Radeon RX 6800 (1700/2105 МГц, 16 Гбит/с, 16 Гбайт);

- AMD Radeon RX 6700 XT (2321/2581 МГц, 16 Гбит/с, 12 Гбайт);

- AMD Radeon RX 6600 XT (2064/2607 МГц, 16 Гбит/с, 8 Гбайт);

- AMD Radeon RX 6600 (1626/2491 МГц, 14 Гбит/с, 8 Гбайт);

- AMD Radeon RX 6500 XT (2420/2825 МГц, 18 Гбит/с, 4 Гбайт);

- AMD Radeon RX 5700 XT (1605/1905 МГц, 14 Гбит/с, 8 Гбайт);

- AMD Radeon RX 5700 (1465/1725 МГц, 14 Гбит/с, 8 Гбайт);

- AMD Radeon RX 5600 XT (1235/1620 МГц, 12 Гбит/с, 6 Гбайт);

- AMD Radeon RX 5500 XT (1607/1845 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 4090 (2235/2535 МГц, 21 Гбит/с, 24 Гбайт);

- NVIDIA GeForce RTX 4080 (2205/2505 МГц, 22,4 Гбит/с, 16 Гбайт);

- NVIDIA GeForce RTX 4070 Ti (2310/2610 МГц, 21 Гбит/с, 12 Гбайт);

- NVIDIA GeForce RTX 4070 (1920/2550 МГц, 21 Гбит/с, 12 Гбайт);

- NVIDIA GeForce RTX 3090 (1395/1695 МГц, 19,5 Гбит/с, 24 Гбайт);

- NVIDIA GeForce RTX 3080 Ti (1365/1665 МГц, 19 Гбит/с, 12 Гбайт);

- NVIDIA GeForce RTX 3080 (1440/1710 МГц, 19 Гбит/с, 10 Гбайт);

- NVIDIA GeForce RTX 3070 Ti (1575/1770 МГц, 19 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 3070 (1500/1730 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 3060 Ti (1410/1665 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 3060 (1320/1837 МГц, 15 Гбит/с, 12 Гбайт);

- NVIDIA GeForce RTX 3050 (1550/1780 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2080 Ti Founders Edition (1350/1635 МГц, 14 Гбит/с, 11 Гбайт);

- NVIDIA GeForce RTX 2080 SUPER (1650/1815 МГц, 15,5 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2080 Founders Edition (1515/1800 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2070 SUPER (1605/1770 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2070 Founders Edition (1410/1710 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2060 SUPER (1470/1650 МГц, 14 Гбит/с, 8 Гбайт);

- NVIDIA GeForce RTX 2060 (1365/1680 МГц, 14 Гбит/с, 6 Гбайт);

- Intel Arc A770 (2100/2400 МГц, 17,5 Гбит/с, 16 Гбайт);

- Intel Arc A750 (2050/2400 МГц, 16 Гбит/с, 8 Гбайт);

- Intel Arc A380 (2000/2450 МГц, 15,5 Гбит/с, 6 Гбайт).

Прим. В скобках после названий видеокарт указаны базовая и boost-частота согласно спецификациям каждого устройства. Видеокарты с заводским разгоном приведены в соответствие с референсными параметрами (или приближены к последним) при условии, что это можно сделать без ручной правки кривой тактовых частот. В противном случае используются настройки производителя.