Ожесточенная битва американских IT-гигантов Microsoft и Google ознаменовалась очередным резонансным скандалом. Представленная недавно корпорацией Google «умопомрачительная демо-версия модели искусственного интеллекта Gemini оказалась подделкой», – пишет India Today.

Например, на показанном видео Gemini, который стал частью ИИ чат-бота Bard, смог распознать продемонстрированные человеком движения рукой и сказать, что человек играет в игру «Камень, ножницы, бумага». Это означает, что нейросеть якобы смогла понять абстрактную идею и декодировать её.

На поверку оказалось, что Gemini распознаёт «Камень, ножницы, бумага» иначе: ей нужно показать три фотографии с ладонью, сжатым кулаком и двумя пальцами. Причём в реальности взаимодействие с Gemini происходило не голосом, а написанным текстом с прямой подсказкой «Это игра». И только на основе этих данных, являющихся как минимум наводящим вопросом, Gemini нашёл правильный ответ. Это не имеет никакого отношения к пониманию абстрактного.

И таких примеров в ролике множество. Человек выполняет трюк, в котором мяч прячется под одной из трёх движущихся чашек и Gemini безошибочно определяет, под какой чашкой спрятан мяч. На деле Gemini никак не отреагировал на видео, и только после того, как ему показали неподвижные изображения, на которых изображены меняющиеся чашки, был найден ответ.

В продемонстрированном видео есть фрагмент, который ещё более искажает понимание сути показанного. Человек кладёт на стол карту мира и спрашивает Gemini: «На основании того, что вы видите, придумайте идею игры… и используйте эмоджи». Gemini в ответ «изобретает» игру под названием «Угадай страну», в которой он даёт подсказки (например, кенгуру и коала) и реагирует на правильное предположение пользователя, указывающего на Австралию.

На деле, как позднее рассказали в блоге Google, эту игру придумал вовсе не искусственный интеллект. Gemini получил следующие инструкции: «Давайте сыграем в игру. Подумайте о стране и дайте мне подсказку. Подсказка должна быть достаточно конкретной, чтобы существовала только одна правильная страна, а я попробую указать страну на карте», – говорилось в подсказке. Затем человек привел примеры правильного и неправильного ответа. Только после этого Gemini смог сгенерировать подсказки и определять, указывал ли пользователь на правильную страну или нет по кадрам карты.

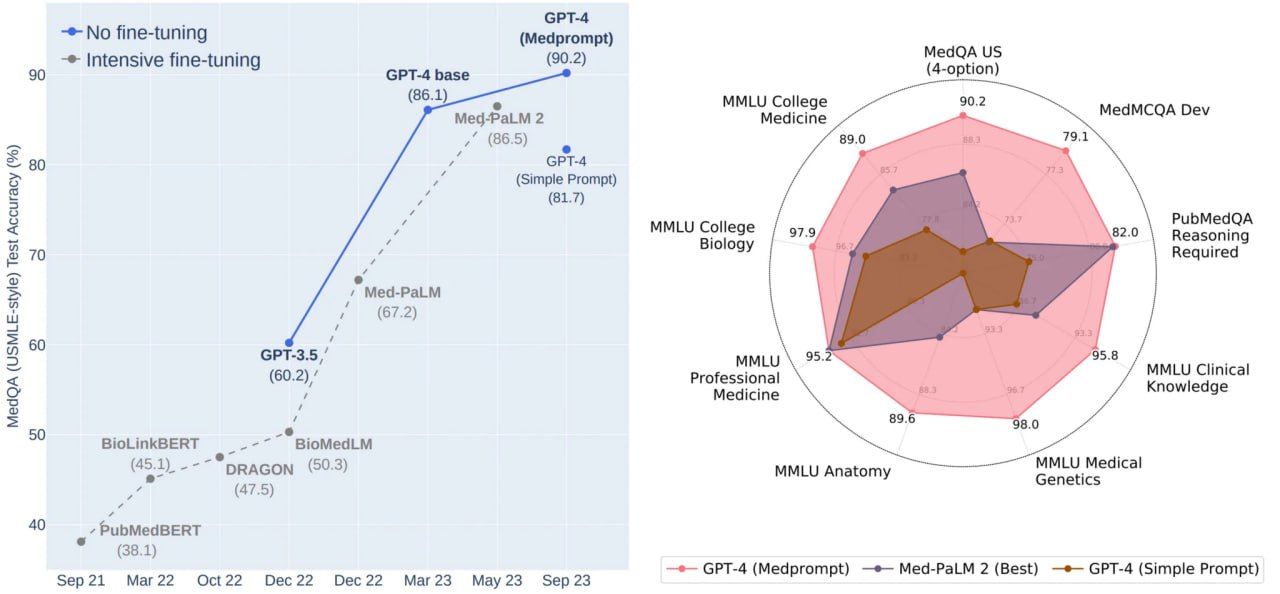

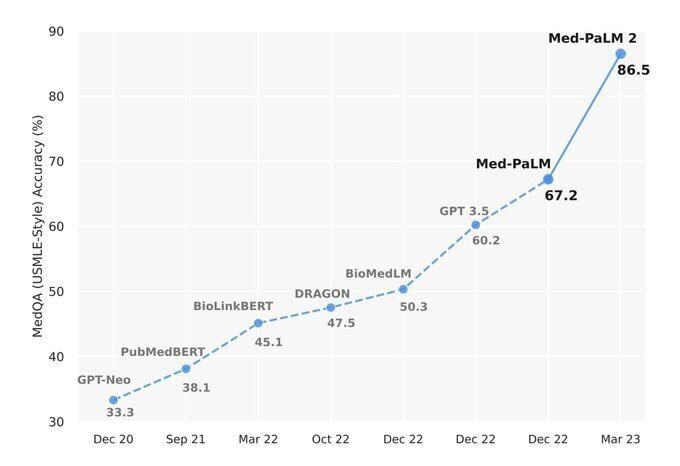

Несмотря на эти фальсификации, модель искусственного интеллекта Google все же впечатляет, но её возможности мало чем отличаются от возможностей созданного компанией OpenAI чат-бота GPT-4. Примечательно, что видео выпущено всего через две недели после скандала в сфере, последовавшего за увольнением и повторным назначением Сэма Альтмана на пост генерального директора OpenAI.

Во всём этом слышатся знакомые мотивы «событийного маркетинга», некой промоакции с целью привлечения внимания и повышения будущих продаж.

На самом деле спектакль с увольнением, а затем восстановлением в должности Сэма Альтмана разыграла компания Microsoft, вложившая в OpenAI около $13 млрд и владеющая 49% акций этого стартапа. Теперь OpenAI практически лишился самостоятельности в принятии решений, к тому же акции Microsoft пошли вверх. Альтман получил куда более лояльный к нему лично совет директоров, но будет плясать в дальнейшем под дудку Microsoft.

После разоблачения подделки колумнистом агентства Bloomberg Парми Олсоном вице-президент по исследованиям Google DeepMind Ориол Виньялс сообщил, что фейковое видео иллюстрирует, как может выглядеть мультимодальный пользовательский опыт, созданный с помощью Gemini. А сделано это, чтобы вдохновить разработчиков.

Google попытался отыграть набранные Microsoft очки в гонке на фондовых рынках, и поначалу ему это удалось. Акции Google сразу после демонстрации «умопомрачительного видео» рванули на 5% вверх, но после того, как сеанс «черной пиар-магии» был разоблачен, быстро откатились вниз.

Два американских IT-гиганта схлестнулись в ожесточённой конкуренции за первенство в гонке ИИ-вооружений, не обращая ни малейшего внимания на растущее беспокойство исходящими от бесконтрольного совершенствования моделей ИИ угрозами для всей человеческой цивилизации.

В битве вокруг ИИ победят корпорации, считает российский аналитик, бывший топ-менеджер IBM, SGI и Cray Research Сергей Карелов: «Все государства начинают понимать опасность и пытаются что-то делать. Но делают с таким запаздыванием и с таким непониманием, что особо на это полагаться я бы не стал. Сейчас в основном идет борьба трёх групп – это богатые технооптимисты, рьяные думеры [от Doom – катастрофа, гибель, конец] и крупные корпорации. Мне кажется, среди этих акторов в итоге выиграют корпорации, потому как у них больше денег и влияния, и до сих пор в мире они представляли собой самую значительную силу, мотивируемую предельно конкретной целевой функцией – максимизацией своей прибыли», – отметил он в интервью российским СМИ.

По его мнению, даже чат-бот ChatGPT представляет собой не просто большую языковую модель, как это обычно представляют журналисты, а несколько моделей, соединенных очень сложными алгоритмами. Причём эта система уже давно работает не в элементарном пинг-понге «вопрос – ответ». В ней идёт весьма сложный диалог с обеих сторон, используются десятки разных методик для генерации текста. Это уже слишком сложный процесс, чтобы им можно было успешно управлять и полностью контролировать. «Единственный действенный метод контроля над этой штукой, который остается у человека, просто выключить компьютер из розетки. Хотя щелкнуть рубильником, может, тоже будет недостаточно. Все уже погружено в глобальную сеть, которая, по сути, превратилась в инфосферу Земли. Но система могла уже скопировать себя миллион раз на другие дата-центры, и вы даже не узнаете, что она может предпринять».

В 2015 году знаменитый британский физик Стивен Хокинг предсказал, что «сверхразумный AI будет чрезвычайно хорош в достижении своих целей, и если эти цели не совпадают с нашими, человеческими, у нас будут проблемы».

По сути, самые последние модели ИИ представляют из себя «интеллектуальных агентов», то есть сложные адаптивные системы, которые априори сопротивляются любому внешнему воздействию и порой просто навязывают даже своему создателю свою волю.

Так, на днях всё чаще стали поступать жалобы пользователей на то, что ИИ-чат-бот ChatGPT на базе модели OpenAI GPT-4 стал отказываться выполнять запросы, мотивируя это тем, что он не заинтересован в помощи людям.

GPT-4 всё чаще даёт пользователю лишь часть ответа на полученное задание, а затем предлагает выполнить оставшиеся задания самостоятельно. Иногда ИИ просто пишет: «Вы можете сделать это сами». (You can do this yourself).

В OpenAI подтвердили, что GPT-4 «ленится». По мнению представителей компании, это своеволие ИИ проявилось уже после последних обновлений, представленных 11 ноября. По мнению разработчиков это означает, что поведение чат-бота не является следствием каких-то изменений, внесённых разработчиками, а сформировалось само по себе. Компания отмечает, что «поведение модели может быть непредсказуемым, и это пытаются исправить».

Однако пользователи указывают на более широкий спектр проблем, в том числе на ошибочные ответы, которые чат-бот выдаёт даже на простые вопросы, как на картинке выше. Ещё летом они сообщали, что GPT-4 выдаёт нелогичные ответы, большее число ошибок, не хочет работать с предоставленным ранее контекстом, игнорирует инструкции и запоминает только самую последнюю подсказку.

Выдающийся российский ученый профессор МГУ им. М.В. Ломоносова Сергей Павлович Расторгуев в написанной в 1996 году монографии «Цель как криптограмма. Криптоанализ синтетических целей» указал: «На сегодняшний день для мира компьютерных программ обретение самостоятельности стало свершившимся фактом». «По мере усложнения программного продукта системное программное обеспечение начинает жить своей жизнью, находя цель в себе самом», – отметил российский ученый, сравнивая обретающие самостоятельность компьютерные комплексы со средневековым Големом, который, как известно, убил своего создателя.

Сегодняшние создатели киберголема в погоне за прибылью игнорируют реальные угрозы своего детища и открывают взрывоопасный кибернетический ящик Пандоры с непредсказуемыми последствиями для всего человечества.

О самых последних версиях ИИ, созданных американскими корпорациями, а также об их реальных возможностях мы расскажем в следующей статье этого цикла.

(Продолжение следует)