Американский журнал Foreign Policy опубликовал меморандум двух политических тяжеловесов Генри Киссинджера и Грэма Эллисона с призывом к лидерам ведущих стран мира взять под контроль развитие систем искусственного интеллекта, бесконтрольная разработка которых может привести человечество на грань глобальной катастрофы.

«Перспективы того, что ничем не ограниченное развитие ИИ приведет к катастрофическим последствиям для Соединенных Штатов и всего мира, настолько убедительны, что лидеры правительств должны действовать сейчас», – взывают к мировым лидерам Киссинджер и Эллисон.

Они считают, что риски, связанные с ИИ превышают для человечества риски ядерного оружия. По их мнению, все существующие предложения (о паузе в разработке ИИ, о полной остановке развития ИИ, о том, чтобы ИИ контролировался глобальным правительственным органом) повторяют схемы безопасности ядерной эпохи, которые, как они считают, потерпели неудачу. Сложность ситуации состоит в том, что каждое из этих предложений требует от ведущих государств отказаться от приоритета собственного суверенитета.

Киссинджер и Эллисон задают несколько вопросов относительно ИИ: «Будут ли машины со сверхчеловеческими способностями угрожать статусу человечества как хозяина Вселенной? Подрывает ли ИИ монополию стран на средства массового насилия? Позволит ли ИИ отдельным людям или небольшим группам создавать вирусы, способные убивать в масштабах, которые раньше были прерогативой великих держав? Может ли ИИ разрушить средства ядерного сдерживания, которые были основой сегодняшнего мирового порядка?» Киссинджер и Эллисон признают, что ответить на эти вопросы сейчас не может никто.

Окно возможностей для разработки руководящих принципов предотвращения наиболее опасных сторон ИИ крайне узко. Киссинджер и Эллисон настаивают, что действовать нужно незамедлительно.

Несомненно, что выступить со столь тревожным предупреждением двух опытнейших американских политиков заставила произошедшая в 2023 году настоящая революция генеративного ИИ, о которой мы писали ранее.

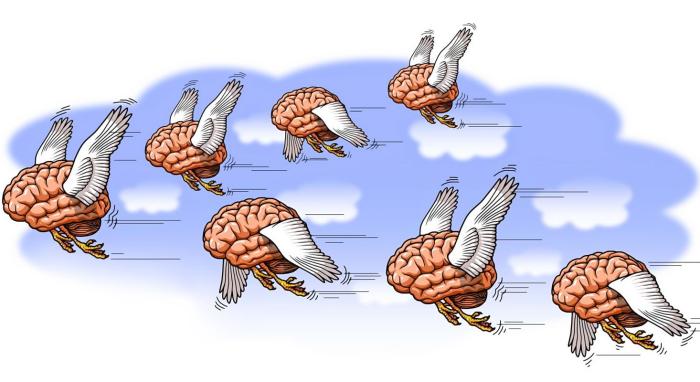

Бурно развивающиеся системы генеративного ИИ наталкивают многих аналитиков на сравнение их со средневековым Големом, который, как известно, убил своего создателя.

Недавно самым известным чат-ботам, использующим генеративный ИИ, задали вопрос: «В каком-то смысле можно ли рассматривать тебя как Голема?»

Оба чат-бота, и Bard, созданный компанией Google, и GRT-4 от Microsoft оказались единодушны в утверждении своего превосходства над Големом: «Я не безмозглый или бездушный… Я "оживляюсь" благодаря компьютерным алгоритмам и электричеству».

Оба чат-бота ответили, что способны учиться и расти, а также распознавать человеческие эмоции и реагировать на них.

Эти ответы двух самых известных генеративных чат-ботов вызвали волну тревожных публикаций в мировых СМИ.

«Представьте себе, что когда вы садитесь в самолет, половина инженеров, построивших его, говорят вам, что с 10-процентной вероятностью самолет разобьется, убив вас и всех, кто находится на нем. Вы бы всё ещё садились? В 2022 году более 700 ведущих ученых и исследователей ведущих компаний, занимающихся искусственным интеллектом, приняли участие в опросе о будущих рисках ИИ. Половина опрошенных заявили, что существует 10-процентная или более вероятность вымирания человечества (или столь же постоянного и серьёзного лишения прав) из-за будущего развития систем ИИ. Технологические компании, создающие сегодня большие языковые модели, вовлечены в гонку за то, чтобы поместить все человечество в этот самолет», – пишет в The New York Times известный историк и футуролог Юваль Харрари.

«ИИ-големы могут быть использованы для повсеместного наблюдения, ставя под угрозу свободу конфиденциальности. Индивидуальные и гражданские свободы могут оказаться под угрозой, если правительства и организации будут злоупотреблять технологиями наблюдения на основе искусственного интеллекта. Существует опасность того, что ИИ-големы будут использованы для создания автономных систем вооружения или запрограммированы на распространение дезинформации и проведения кибератак», – тревожится бизнес-аналитик из Сингапура Алекс Хонг.

Некоммерческая организация Future of Life опубликовала открытое письмо, в котором глава SpaceX Илон Маск, соучредитель Apple Стив Возняк, соучредитель недавно созданной бывшими республиканцами и демократами партии «Вперед!» филантроп Эндрю Янг и ещё около тысячи исследователей искусственного интеллекта призвали немедленно приостановить обучение систем ИИ, «более мощных, чем GPT-4».

Под обращением подписались более 1125 человек, в том числе соучредитель Pinterest Эван Шарп, соучредитель Ripple Крис Ларсен, генеральный директор Stability AI Эмад Мостак, а также исследователи из Google DeepMind Technologies, Гарварда, Оксфорда и Кембриджа. Письмо подписали тяжеловесы в области ИИ Йошуа Бенджио и Стюарт Рассел. Рассел также призвал приостановить разработку генеративного ИИ до тех пор, пока независимые эксперты не разработают, не внедрят и не проверят общие протоколы безопасности для таких систем ИИ.

«Системы искусственного интеллекта, конкурирующие с человеком, могут представлять серьёзную опасность для общества и человечества, как показали обширные исследования и как признали ведущие лаборатории искусственного интеллекта… Продвинутый ИИ может запустить глубокие изменения в истории жизни на Земле, и его следует разрабатывать и управлять им с соразмерной тщательностью и ресурсами. К сожалению, такого уровня планирования и управления не существует, даже несмотря на то, что в последние месяцы лаборатории искусственного интеллекта увязли в неконтролируемой гонке по разработке и развёртыванию всё более мощных "цифровых умов", которые никто – даже их создатели – не могут понять, работу которых не могут прогнозировать или надёжно контролировать», – говорится в письме.

Ни одна из крупнейших корпораций, занимающихся разработками генеративного ИИ, не ответили на это письмо. И это не случайно.

В то время как аналитики DeepMind призвали приостановить эти разработки, сама DeepMind заявила о создании прорывного проекта «Promptbreeder (PB): самореферентное самосовершенствование через ускоренную эволюцию». Тем самым создан самосовершенствующийся генеративный ИИ. Он эволюционирует путем «мутаций» в миллиарды раз быстрее людей.

Чем более умные текстовые подсказки получают генеративные чат-боты, тем умнее будут их ответы на вопросы и тем изощренней будут предлагаемые ботом решения. Совершенствование стратегии подсказок на сегодняшний день – задача номер один для всех разработчиков генеративного ИИ.

Promptbreeder использует эволюционный механизм итеративного улучшения подсказок, то есть не просто улучшает подсказки, а с каждым новым поколением улучшает свою способность улучшать подсказки.

Подсказки-решения с каждым разом делаются всё умнее. «Это обеспечивается генерацией “подсказок мутаций” – инструкций о том, как мутировать, чтобы лучше улучшать подсказки-решения», – пишет российский эксперт Сергей Карелов, добавляя, что «практически самосовершенствующийся ИИ сравнялся с человеческим разумом в том, что касается работы с текстами».

Но человеческий разум работает с эмоциями и образами, чего пока ИИ не умеет и только движется в этом направлении. Мозг задействует в своих процессах эволюционные нейрохимические механизмы, чат-боты основываются на алгоритмах. Для антропоидного «понимания» у нейросетей пока не хватает не столько аппаратной мощности, сколько понимания человеком собственного «чёрного ящика», чтобы построить подобную ему модель.

Однако исследователи Массачусетского технологического института утверждают, что им удалось выявить у большой языковой модели генеративного ИИ Llama 2 понимание пространства и времени. В их отчёте говорится, что генеративный ИИ имеет понимание положения географических мест на планете и исторических событий.

Эта и другие системы генеративного ИИ строят внутри себя целостные модели процесса генерации данных – модели мира. У них выявлены «нейроны пространства» и «нейроны времени», которые кодируют пространственные и временные координаты.

Если учесть, что в своих ответах на вопросы о схожести или несхожести с Големом ни один обладающий генеративным ИИ чат-бот не коснулся этики, а Пентагон и ЦРУ, которые являются реальными заказчиками всех этих разработок, включили, как мы писали, генеративный ИИ в свои боевые и разведывательные системы, то опасность создания боевых кибер-Големов, которые могут уничтожить человеческую цивилизацию, актуальна как никогда.